Windows配置heritrix3做网络爬虫开发实例

发布于 2016-07-02 01:57:02 | 135 次阅读 | 评论: 0 | 来源: 网友投递

Heritrix web爬虫

Heritrix是一个开源,可扩展的web爬虫项目。用户可以使用它来从网上抓取想要的资源。Heritrix设计成严格按照robots.txt文件的排除指示和META robots标签。其最出色之处在于它良好的可扩展性,方便用户实现自己的抓取逻辑。

一、引言:

最近在忙某个商业银行的项目,需要引入外部互联网数据作为参考,作为技术选型阶段的工作,之前已经确定了中文分词工具,下一个话题就是网络爬虫的选择,目标很明确,需要下载一些财经网站的新闻信息,然后进行文本计算。记得上一次碰爬虫还是5年前,时过境迁,不知道爬虫的世界里是否有了新的崛起。比较过一些之后,初步认定Heritrix基本能够满足需要,当然肯定是需要定制的了。

二、版本选择

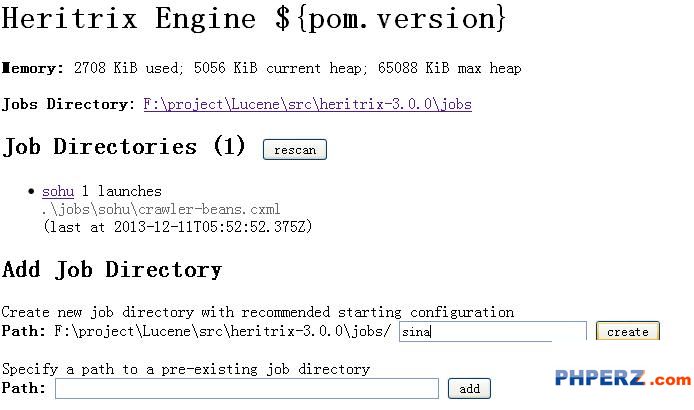

Heritrix当前版本3.1.0,安装后发现,启动任务时,Windows平台有BDBOpen的错误(具体原因不详),Linux环境没有测试。度娘了一把,没啥实质性收获,如果从源码去看,又太费时间。就换到了3.0.5,这个版本也有问题,就是创建Job时,总是提示文件夹有问题,可以选择手动创建下载任务。操作界面如下图所示:

三、配置任务-手动

1.jobs目录下新建文件夹sohu;

2.拷贝模板文件profile-crawler-beans.cxml到sohu目录

3.重命名profile-crawler-beans.cxml文件为crawler-beans.cxml

4.手动修改文件crawler-beans.cxml,设置目标网站和存储方式:

# This Properties map is specified in the Java 'property list' text format

# <a href="http://java.sun.com/javase/6/docs/api/java/util/Properties.html#load%28java.io.Reader%29">http://java.sun.com/javase/6/docs/api/java/util/Properties.html#load%28java.io.Reader%29</a></p> <p>metadata.operatorContactUrl=http://localhost

metadata.jobName=sohu

metadata.description=sohujingxuan</p> <p>##..more?..##

</value>

</property>

</bean></p> <p> <!-- overrides from declared <prop> elements, more easily allowing

multiline values or even declared beans -->

<bean id="longerOverrides" class="org.springframework.beans.factory.config.PropertyOverrideConfigurer">

<property name="properties">

<props>

<prop key="seeds.textSource.value"></p> <p># URLS HERE

<a href="http://t.sohu.com/jingxuan">http://t.sohu.com/jingxuan</a></p> <p> </prop>

</props>

</property>

</bean></p> <p> <!-- CRAWL METADATA: including identification of crawler/operator -->

<bean id="metadata" class="org.archive.modules.CrawlMetadata" autowire="byName">

<property name="operatorContactUrl" value="<a href="http://localhost"/">http://localhost"/</a>>

<property name="jobName" value="sohu"/>

<property name="description" value="sohujingxuan"/>

<!-- <property name="operator" value=""/> -->

<!-- <property name="operatorFrom" value=""/> -->

<!-- <property name="organization" value=""/> -->

<!-- <property name="audience" value=""/> -->

<!-- <property name="userAgentTemplate"

value="Mozilla/5.0 (compatible; <a href="mailto:heritrix/@VERSION">heritrix/@VERSION</a>@ <a href="mailto:+@OPERATOR_CONTACT_URL@)"/">+@OPERATOR_CONTACT_URL@)"/</a>> -->

</bean>

四、停用Robots检查

改造函数,禁用Robots协议检查,目的就不说了,改造方法如下:

private boolean considerRobotsPreconditions(CrawlURI curi) {

// treat /robots.txt fetches specially

//++zhangzl:取消robots.txt的强制限制

return false;

//--</p> <p> }

五、后续工作

1.定向下载改造:只下载目标内容,过滤无关信息。

2.自动解析改造:下载内容自动解析到指定目录,指定格式。