Lucene Field选项

发布于 2015-07-25 11:31:08 | 419 次阅读 | 评论: 0 | 来源: 网络整理

Field 是最重要的和索引进程的基础单元。它是要索引包含的内容的实际对象。当我们添加一个字段,Lucene提供使用Field 项字段,其中规定字段是要搜索的许多控制。

我们添加包含字段IndexWriter,IndexWriter用于更新或创建索引文件。

现在,我们将展示一个循序渐进的过程,以获得一个开始在使用基本的例子,在不同 Field 选项的理解。

各种Field选项

-

Index.ANALYZED - 先分析然后做索引。用于普通的文本索引。分析仪将打断该字段的值转换成标记流,每个令牌是搜索分开。

-

Index.NOT_ANALYZED - 不分析,但这样做索引。用于完整的文本索引,例如人的名字,URL等。

-

Index.ANALYZED_NO_NORMS - 变式Index.ANALYZED。分析仪将打破该字段的值转换成标记流,每个令牌是搜索分开,但规范是不存储在indexes.NORMS被用来提高搜索但有时内存消耗。

-

Index.Index.NOT_ANALYZED_NO_NORMS - 变式Index.NOT_ANALYZED。索引是这样做,但规范NORMS是不存储在索引。

-

Index.NO - 字段值不搜索。

使用Field选项

-

创建一个方法来从文本获取Lucene的文档。

-

创建各种类型的是含有键作为名称和值作为内容被编入索引键值对字段。

-

设置字段进行分析与否。在这里,只有内容是要被分析,因为它可能包含数据,诸如,a, am, are, an等它不要求在搜索操作等等。

-

新创建的字段添加到文档对象并返回给调用者的方法。

private Document getDocument(File file) throws IOException{

Document document = new Document();

//index file contents

Field contentField = new Field(LuceneConstants.CONTENTS,

new FileReader(file));

//index file name

Field fileNameField = new Field(LuceneConstants.FILE_NAME,

file.getName(),

Field.Store.YES,Field.Index.NOT_ANALYZED);

//index file path

Field filePathField = new Field(LuceneConstants.FILE_PATH,

file.getCanonicalPath(),

Field.Store.YES,Field.Index.NOT_ANALYZED);

document.add(contentField);

document.add(fileNameField);

document.add(filePathField);

return document;

}

应用程序示例

让我们创建一个测试Lucene的应用程序来测试索引处理。

| 步骤 | 描述 |

|---|---|

| 1 | 创建一个LuceneFirstApplication在包packagecom.yiibai.lucene下。也可以使用EJB创建的项目 |

| 2 | 创建LuceneConstants.java,TextFileFilter.java和Indexer.java。保持其它的文件不变。 |

| 3 | 创建LuceneTester.java如下所述。 |

| 4 | 清理和构建应用程序,以确保业务逻辑按要求工作。 |

LuceneConstants.java

这个类是用来提供可应用于示例应用程序中使用的各种常量。

package com.yiibai.lucene;

public class LuceneConstants {

public static final String CONTENTS="contents";

public static final String FILE_NAME="filename";

public static final String FILE_PATH="filepath";

public static final int MAX_SEARCH = 10;

}

TextFileFilter.java

此类用于 .txt文件过滤器。

package com.yiibai.lucene;

import java.io.File;

import java.io.FileFilter;

public class TextFileFilter implements FileFilter {

@Override

public boolean accept(File pathname) {

return pathname.getName().toLowerCase().endsWith(".txt");

}

}

Indexer.java

这个类是用于索引的原始数据,这样我们就可以使用Lucene库,使其可搜索。

package com.yiibai.lucene;

import java.io.File;

import java.io.FileFilter;

import java.io.FileReader;

import java.io.IOException;

import org.apache.lucene.analysis.standard.StandardAnalyzer;

import org.apache.lucene.document.Document;

import org.apache.lucene.document.Field;

import org.apache.lucene.index.CorruptIndexException;

import org.apache.lucene.index.IndexWriter;

import org.apache.lucene.store.Directory;

import org.apache.lucene.store.FSDirectory;

import org.apache.lucene.util.Version;

public class Indexer {

private IndexWriter writer;

public Indexer(String indexDirectoryPath) throws IOException{

//this directory will contain the indexes

Directory indexDirectory =

FSDirectory.open(new File(indexDirectoryPath));

//create the indexer

writer = new IndexWriter(indexDirectory,

new StandardAnalyzer(Version.LUCENE_36),true,

IndexWriter.MaxFieldLength.UNLIMITED);

}

public void close() throws CorruptIndexException, IOException{

writer.close();

}

private Document getDocument(File file) throws IOException{

Document document = new Document();

//index file contents

Field contentField = new Field(LuceneConstants.CONTENTS,

new FileReader(file));

//index file name

Field fileNameField = new Field(LuceneConstants.FILE_NAME,

file.getName(),

Field.Store.YES,Field.Index.NOT_ANALYZED);

//index file path

Field filePathField = new Field(LuceneConstants.FILE_PATH,

file.getCanonicalPath(),

Field.Store.YES,Field.Index.NOT_ANALYZED);

document.add(contentField);

document.add(fileNameField);

document.add(filePathField);

return document;

}

private void indexFile(File file) throws IOException{

System.out.println("Indexing "+file.getCanonicalPath());

Document document = getDocument(file);

writer.addDocument(document);

}

public int createIndex(String dataDirPath, FileFilter filter)

throws IOException{

//get all files in the data directory

File[] files = new File(dataDirPath).listFiles();

for (File file : files) {

if(!file.isDirectory()

&& !file.isHidden()

&& file.exists()

&& file.canRead()

&& filter.accept(file)

){

indexFile(file);

}

}

return writer.numDocs();

}

}

LuceneTester.java

这个类是用来测试Lucene库的索引能力。

package com.yiibai.lucene;

import java.io.IOException;

public class LuceneTester {

String indexDir = "E:\Lucene\Index";

String dataDir = "E:\Lucene\Data";

Indexer indexer;

public static void main(String[] args) {

LuceneTester tester;

try {

tester = new LuceneTester();

tester.createIndex();

} catch (IOException e) {

e.printStackTrace();

}

}

private void createIndex() throws IOException{

indexer = new Indexer(indexDir);

int numIndexed;

long startTime = System.currentTimeMillis();

numIndexed = indexer.createIndex(dataDir, new TextFileFilter());

long endTime = System.currentTimeMillis();

indexer.close();

System.out.println(numIndexed+" File indexed, time taken: "

+(endTime-startTime)+" ms");

}

}

数据和索引目录的创建

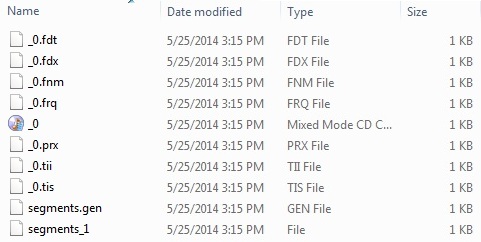

使 用10个文件从 record1.txt 到 record10.txt 的文本文件包含简单的名称以及学生的其他细节,并把它们放在目录 E:LuceneData。这些数据用于测试。索引目录路径应创建为E:LuceneIndex。运行此程序后,就可以看到该文件夹中创建的索引文件的列 表。

运行程序:

一旦创建源,创造了原始数据,数据目录和索引目录来完成,准备好这一步是编译和运行程序。要做到这一点, 在LuceneTester.Java文件选项卡中使用Eclipse IDE 的Run选项,或使用Ctrl+ F11来编译和运行应用程序LuceneTester。如果应用程序一切正常,将在Eclipse IDE控制台打印以下消息:

Indexing E:LuceneDatarecord1.txt

Indexing E:LuceneDatarecord10.txt

Indexing E:LuceneDatarecord2.txt

Indexing E:LuceneDatarecord3.txt

Indexing E:LuceneDatarecord4.txt

Indexing E:LuceneDatarecord5.txt

Indexing E:LuceneDatarecord6.txt

Indexing E:LuceneDatarecord7.txt

Indexing E:LuceneDatarecord8.txt

Indexing E:LuceneDatarecord9.txt

10 File indexed, time taken: 109 ms

一旦成功地运行程序,将有以下的索引目录中的内容: